大模型入门第一课:生成式AI与LLM到底怎么工作的?

导语

之前的文章(https://mp.weixin.qq.com/s/tI95lXiNVtDgC5wtUaCsPQ)分享了 LangChain 的使用方法,很多关注我的朋友私信说没怎么看懂,博主之前是做 Java 开发的,后面自学 Python 转 AI 也有大半年时间了,接下来一个系列,我会用系统化、可落地的方式,带你从“生成式AI入门”一路走到“AI Agent 实战”。

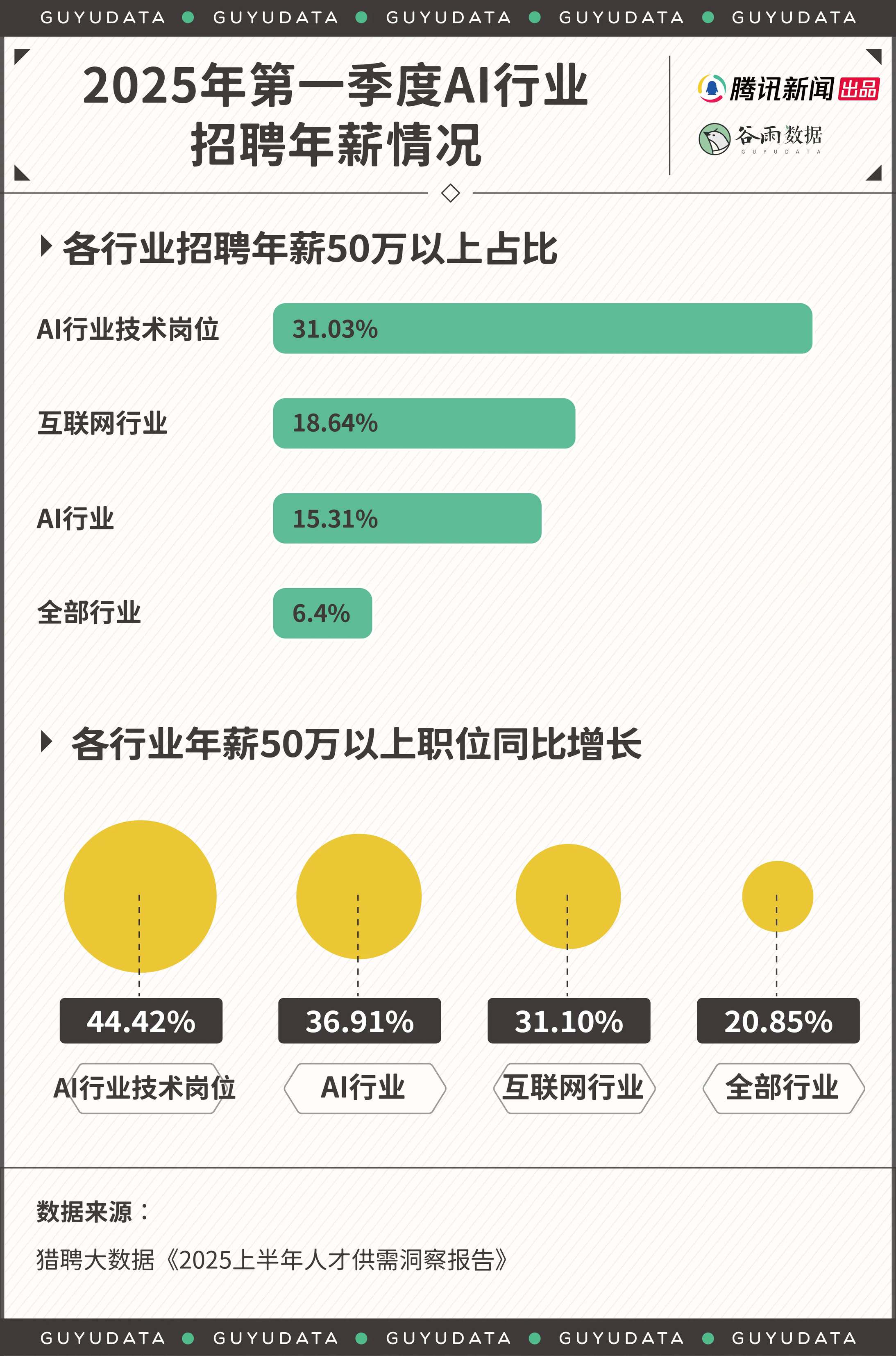

在本次分享开始前,先和大家分享下为何一定要学 AI,以下是 2025 年度第一季度的的最新 AI 行业招聘年薪情况!做过技术的应该都知道,无论是前端还是后端开发,如果没有晋升到管理层以上,技术岗基本上 50 万年薪已经到天花板了,如果想继续吃技术这碗饭并且年薪突破 50 万,目前最佳方式便是转 AI 行业技术岗!

很多人粗浅的认为 AI 就是简单的问答对话,文生图之类的,这只是 AI 最简单的一层应用,说明你还不了解 AI。

今天这篇,先把完整课程路线给大家讲清楚,然后正式开启第一课:《生成式人工智能与大型语言模型简介》。建议先收藏本篇,后续每一课都能顺着学(每篇文章都会附上视频教程,在文章最末尾)。

课程总览(两大阶段,循序渐进)

第一阶段:生成式 AI 入门(1-21)

| 序号 | 课程标题 | 描述 |

|---|---|---|

| 01 | 生成式人工智能和LLM简介 | 学习: 了解什么是生成式人工智能以及大型语言模型(LLM)的工作原理 |

| 02 | 探索和比较不同的LLM | 学习: 如何为你的使用场景选择合适的模型 |

| 03 | 负责任地使用生成式人工智能 | 学习: 如何负责任地构建生成式人工智能应用 |

| 04 | 理解提示工程基础 | 学习: 提示工程最佳实践的动手操作 |

| 05 | 创建高级提示 | 学习: 如何应用提示工程技术以优化提示的结果。 |

| 06 | 构建文本生成应用 | 构建: 使用 Azure OpenAI / OpenAI API 创建文本生成应用 |

| 07 | 构建聊天应用 | 构建: 高效构建和集成聊天应用的技术 |

| 08 | 构建搜索应用与向量数据库 | 构建: 使用嵌入技术进行数据搜索的搜索应用 |

| 09 | 构建图像生成应用 | 构建: 图像生成应用 |

| 10 | 构建低代码 AI 应用 | 构建: 使用低代码工具创建生成式 AI 应用 |

| 11 | 通过函数调用集成外部应用 | 构建: 什么是函数调用及其在应用中的使用场景 |

| 12 | 为 AI 应用设计用户体验 | 学习: 在开发生成式 AI 应用时如何应用用户体验设计原则 |

| 13 | 保护您的生成式 AI 应用 | 学习: AI 系统面临的威胁和风险以及保护这些系统的方法 |

| 14 | 生成式 AI 应用生命周期 | 学习: 管理 LLM 生命周期和 LLMOps 的工具和指标 |

| 15 | 检索增强生成 (RAG) 和向量数据库 | 构建: 使用 RAG 框架从向量数据库中检索嵌入的应用 |

| 16 | 开源模型与 Hugging Face | 构建: 使用 Hugging Face 上的开源模型创建应用 |

| 17 | AI 代理 | 构建: 使用 AI 代理框架创建应用 |

| 18 | 微调 LLM | 学习: 微调 LLM 的意义、原因和方法 |

| 19 | 使用 SLM 构建 | 学习: 使用小型语言模型构建的优势 |

| 20 | 使用 Mistral 模型构建 | 学习: Mistral 系列模型的特点和差异 |

| 21 | 使用 Meta 模型构建 | 学习: Meta 系列模型的特点和差异 |

第二阶段:AI Agent 学习(设计模式到生产实践)

| 序号 | 课程标题 | 描述 |

|---|---|---|

| 01 | AI 代理简介及应用场景 | 学习: 了解什么是AI代理,掌握AI代理的核心概念和主要应用场景 |

| 02 | 探索 AI 代理框架 | 学习: 了解主流AI代理框架的特点,学会选择适合的框架 |

| 03 | 理解 AI 代理设计模式 | 学习: 掌握AI代理的核心设计模式和架构原则 |

| 04 | 工具使用设计模式 | 学习: 学习AI代理如何调用和使用外部工具的设计模式 |

| 05 | 代理式 RAG | 学习: 掌握AI代理结合检索增强生成技术的实现方法 |

| 06 | 构建可信的 AI 代理 | 构建: 创建安全可靠、值得信赖的AI代理系统 |

| 07 | 规划设计模式 | 构建: 实现具备规划和决策能力的AI代理 |

| 08 | 多代理设计模式 | 构建: 构建多个AI代理协同工作的系统 |

| 09 | 元认知设计模式 | 构建: 实现具备自我反思和认知能力的AI代理 |

| 10 | AI 代理的生产应用 | 构建: 将AI代理部署到生产环境的最佳实践 |

| 11 | 使用代理协议 (MCP, A2A 和 NLWeb) | 构建: 学习和实现AI代理间的通信协议 |

| 12 | AI代理的上下文工程 | 学习: 掌握AI代理的上下文管理和工程化方法 |

| 13 | 管理代理记忆 | 学习: 学习AI代理的记忆机制设计和管理策略 |

| 14 | 评估AI代理 | 学习: 掌握AI代理性能评估的方法和指标 |

| 15 | 构建计算机使用代理(CUA) | 构建: 创建能够操作计算机界面的AI代理 |

| 16 | 部署可扩展代理 | 构建: 实现可扩展、高可用的AI代理部署方案 |

| 17 | 创建本地AI代理 | 构建: 构建在本地环境运行的AI代理系统 |

| 18 | 确保AI代理的安全 | 学习: 学习AI代理的安全威胁防护和风险控制方法 |

今天第1课:生成式人工智能与大型语言模型简介

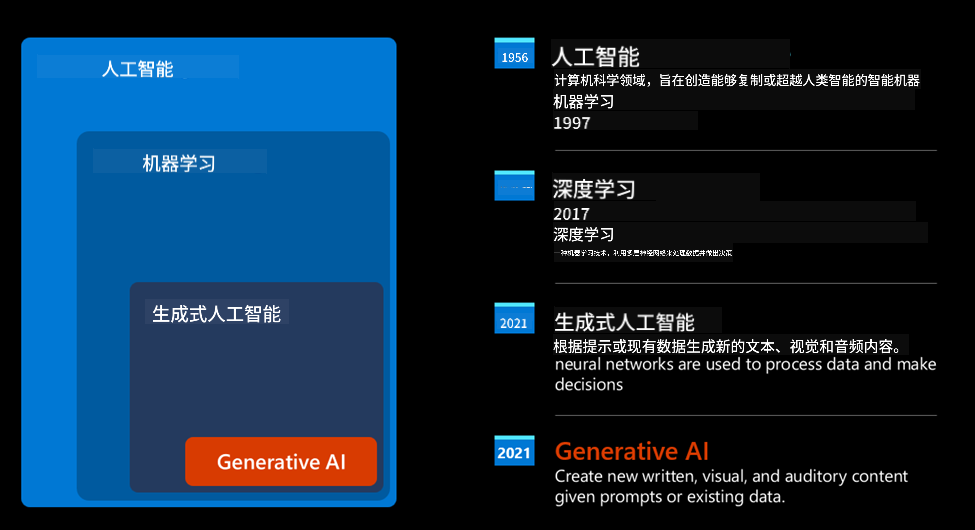

一、生成式AI是什么?

- 用自然语言驱动软件:你说“做什么”,模型替你“怎么做”

- 能生成文本、图像、音频、视频等多模态内容

- 不只是“理解”,还会“创作”“规划”“调用工具执行动作”

二、LLM如何工作?(通俗版原理)

- 分词与数值化:文本会被切成 token,并转成数字,方便模型计算

- 预训练与自回归:在海量语料上学习“下一个词”的概率分布,逐步习得语言与世界知识

- Transformer 与注意力:通过“注意力机制”在长文本中聚焦关键信息,突破RNN长依赖限制

- 采样与输出:温度、Top-k/Top-p等参数决定“更稳妥”还是“更有创造力”

三、LLM 它到底能做什么?(核心能力)

- 自然语言处理:总结、改写、翻译、写作、信息抽取

- 结构化输出:按JSON/表格返回结果,便于系统集成

- 工具使用(函数调用):连通数据库、计算引擎、搜索、第三方API

- 代码相关:生成、解释、重构、单测、调试建议

- 多轮对话:理解上下文、持续跟进任务

四、一个典型落地场景:教育

- 个性化辅导:因材施教,因时反馈

- 作业批改与讲评:指出知识点与可操作改进

- 内容生成:讲义、练习、题库、课件、示例

- 教学助理:检索课程资料、生成课堂互动、组织复习

- 风险提示:考试评测等高风险场景须强监管与可追溯

五、负责任的AI:边界与底线

- 减少“幻觉”:结合检索(RAG)与引用来源

- 安全与对齐:规避敏感、有害内容与越权调用

- 隐私合规:数据采集、存储与使用全链路合规

- 可评估与可监控:用指标说话,持续测试与灰度

六、开发者落地路线(实践清单)

- 选模型:商业API(如通用大模型)或开源自部署(成本与可控)

- 写提示词:角色+约束+示例+输出格式,优先结构化

- 接入RAG:用向量检索把“私有知识”供给模型,降低幻觉

- 接入工具:函数调用连接数据库、搜索、算子、业务系统

- 评估闭环:小样本评测→A/B→埋点监控→持续优化

- 性能与成本:缓存、批处理、流式输出、分层模型(先小后大)

七、常见坑与建议

- 一味追求“大”,忽视工程与体验:先把数据、提示、评估打牢

- 只做“问答”:要逐步引入工具调用与任务编排,做真正“能干活”的系统

- 没有监控与评估:上线后一定要有指标与报警,否则问题不可控

- 忽略隐私与安全:尤其在企业内网、医疗、教育等敏感场景

小结

生成式AI不是“魔法黑箱”,而是一套可以工程化落地的技术栈。理解它的原理与边界,结合RAG和函数调用,配合评估与监控,你就能把“自然语言驱动软件”的能力用在真实场景里。

视频教程

https://48673fs5cb16.vicp.fun/quanyouhulian/1、生成式人工智能和LLM简介.mp4

视频内容介绍:

- 我们的启动想法和使命简介。

- 生成式 AI 以及我们如何登陆当前技术格局。

- 大型语言模型的内部工作。

- 大型语言模型的主要功能和实际用例。

下节分享预告

第2课:探索与比较不同的LLM——从模型能力、成本、延迟、上下文长度、生态与可用性全维度做选型指南。

大模型入门第一课:生成式AI与LLM到底怎么工作的?

http://example.com/2025/09/16/后端技术互联/大模型入门第一课:生成式AI与LLM到底怎么工作的?/